Cloud TPU: Google baut Monster-Hardware für Machine-Learning

Die zweite Generation von Googles TPU kann nicht nur Modelle anwenden, sondern beschleunigt auch massiv das Training für maschinelles Lernen. Ein Cluster aus 64 der neuen TPU erreicht 11,5 PFlops und kann in der Cloud gemietet werden.

Während Nvidia vergangene Woche noch seine neuen Grafikkarten für maschinelles Lernen angepriesen hat, sind auch GPUs für die Bedürfnisse von Google inzwischen zu langsam. Das Unternehmen hat deshalb eine zweite Generation seiner sogenannten Tensor Processing Units (TPU) vorgestellt, die nicht nur das Inferencing beschleunigen, sondern auch explizit das Training völlig neuer Modelle, wie Google-Chef Sundar Pichai auf der Google I/O bekräftigt.

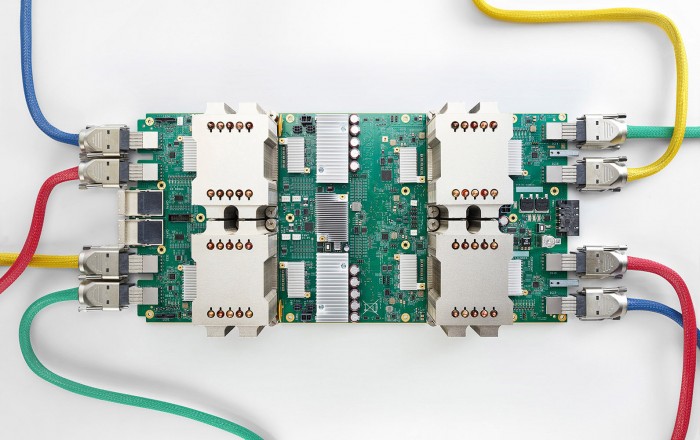

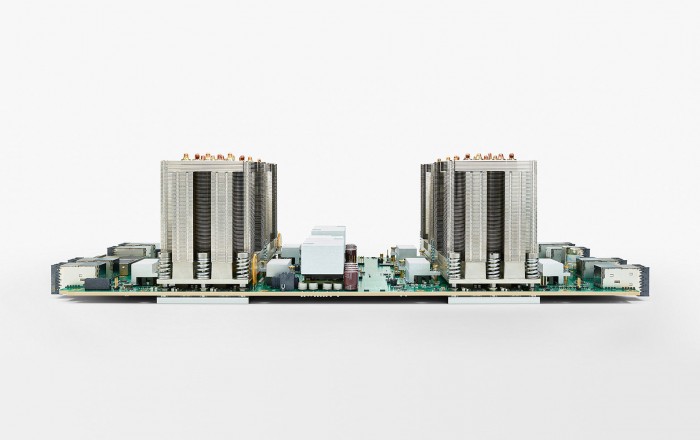

Eine einzelne Einheit der zweiten Generation der TPU bietet laut Google eine Leistung von 180 Teraflops, wie es in der offiziellen Ankündigung heißt. Diese TPU wiederum besteht den Bildern zufolge aus vier dedizierten Chips auf einem Board. Zum Vergleich: Nvidias neue Tesla V100, die erst Ende dieses Jahres verfügbar sein wird, bietet eine theoretische Rechenleistung von 120 Teraflops. Dank einem eigenem "Hochgeschwindigkeitsnetzwerk" kann Google die neuen TPU zu einem Pod aus 64 einzelnen Geräten zusammenfassen. Dieser TPU-Pod liefere dann 11,5 Petaflops Rechenleistung. Google nutzt diese Systeme eigenen Angaben zufolge bereits zum Trainieren seiner Modelle.

Die schiere Leistung der neuen TPU zeigt sich im Vergleich zu bisheriger GPU-Hardware. So benötigte das Trainieren eines neuronalen Netzes für die Übersetzung "auf 32 der besten kommerziell verfügbaren GPUs" einen ganzen Tag. Mit den neuen TPUs reiche für das Training dagegen nur einen "Nachmittag", bei der Verwendung von einem Achtel des TPU-Pods, also 8 TPU-Einheiten. Die erste Generation der TPU hat ausschließlich das Inferencing, also das Anwenden eines bereits trainierten Modells beschleunigt.

Kunden von Googles Cloud-Angeboten können auf die zweite Generation der TPU über das Angebot Cloud TPU zugreifen und diese gemeinsam mit dem Machine-Learning-Framework Tensorflow nutzen. Das Angebot steht derzeit als anmeldepflichtige Alpha bereit. Für Forscher, die sich die Nutzung der Cloud TPU nicht leisten können, bietet Google einen kostenlosen Zugang zu 1000 der Cloud TPU an. Organisiert wird dies über die Tensorflow Research Cloud.

Trotz der Einführung der Cloud TPU will Google sein Angebot der Cloud GPU weiter anbieten. Diese nutzen bisher GPUs von Nvidia.

Oder nutzen Sie das Golem-pur-Angebot

und lesen Golem.de

- ohne Werbung

- mit ausgeschaltetem Javascript

- mit RSS-Volltext-Feed

Richtig, die kleinen Einzelschritte sind nicht besonders intelligent, sie aber alle von...

Tust du hier nix du text

Alle anderen Benchmarks sind irrelevant.

Es müsste ja nicht nur DNA "simulieren" sondern sämtliche Differenzierungs-, Lebens- und...