Xavier-Tegra: Nvidia entwickelt eigene TPU für autonome Autos

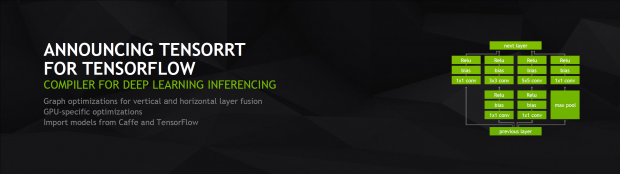

Googles Deep-Learning-Beschleuniger TPU lassen sich nur in der Cloud mieten. Nvidia will ähnliche Chips künftig als Teil seiner Xavier-SoCs verkaufen und als Open Source anbieten.

Auf der GTC Europe 2016 in London hat Nvidia den Xavier-Chip vorgestellt. Das SoC nutzt 512 Shader-Kerne mit Volta-Architektur und laut Nvidia auch sogenannte Computer-Vision-Beschleuniger. Dahinter verbergen sich Funktionseinheiten, die pro Takt doppelt so viele INT8- wie FP16-Berechnungen durchführen können. Nvidia bezeichnet diese auf der GTC 2017 nun offiziell als DLA (Deep Learning Accelerator). Gedacht sind die DLA für das Inferencing beim maschinellen Lernen und im Xavier-SoC für den Automotive-Markt.

Dort werden Nvidias Tegras häufig eingesetzt, neuester Partner ist Toyota - der momentan größte Automobilhersteller der Welt. Auf der CES 2017 kündigte Nvidia bereits Audi, ZF und Bosch als Partner an. Den Einsatzzweck für die DLA benennt Nvidia entsprechend sehr deutlich: autonome Autos.

Dedizierte Einheiten zur Modellanwendung

Obwohl Nvidia die DLA zuvor noch als Computer-Vision-Beschleuniger bezeichnet hat, können diese prinzipiell auch für jede andere Deep-Learning-Aufgabe genutzt werden. Mit den DLA lassen sich so zusätzlich zur Modellverarbeitung bei der Bilderkennung auch die Umgebungsdaten unterschiedlicher Sensoren analysieren.

Die DLA-Einheiten sind wie bei den TPU von Google nicht für das Training von neuronalen Netzen gedacht. Das wird von der GPU mit Shader-Kernen erledigt. Stattdessen hat Nvidia die DLA für das sogenannte Inferencing ausgelegt, diese beschleunigen also ein für einen bestimmten Zweck angelerntes Netz, um etwa spezifische Details eines eingelesenen Bildes zu erkennen.

Auf der GTC 2017 in San Jose gab Nvidia eine Leistung von 30 Teraops bei 30 Watt für den Xavier-Chip an, eine frühere Angabe lautete 20 TOPS bei 20 Watt. Googles TPU schaffen bei einer maximalen TDP von 75 Watt bei 700 MHz immerhin 91,8 TOPS. Anders als die DLA von Nvidia im Xavier-SoC können Googles TPU aber nicht gekauft, sondern nur in den Cloud-Diensten von Google gemietet werden.

Vages Open-Source-Versprechen

Bei der Ankündigung der DLA sagte Nvidia-Chef Jensen Huang: "Wir machen die Xavier DLA Open Source". Was genau damit gemeint ist, ist allerdings unklar. Dass Nvidia die eigentliche Hardware offenlegen wird, wäre angesichts der bisherigen Firmenpolitik ein geradezu revolutionärer Umbruch und damit eher unwahrscheinlich.

Vermutlich wird allerdings der Open-Source-Support, etwa durch Treiber, Compiler und Werkzeuge, relativ weitgehend ausfallen. Für die bisherigen Tegra-Chips hat Nvidia zum Beispiel auch den freien Linux-Grafiktreiber Nouveau aktiv unterstützt und an dessen Entwicklung mitgewirkt.

Oder nutzen Sie das Golem-pur-Angebot

und lesen Golem.de

- ohne Werbung

- mit ausgeschaltetem Javascript

- mit RSS-Volltext-Feed